Например, если бот обходит 60 URL-адресов в сутки, то на https://deveducation.com/ ваш сайт выделяется 1800 страниц краулингового бюджета ежемесячно. А краулинговый бюджет — это лимит сканирования страниц, который выделяет поисковая система для каждого сайта. То есть, это ограниченное количество контента, индексируемое роботом в определенный временной отрезок. Чтобы среди разнообразия найти самые релевантные варианты и вывести их в топ выдачи, поисковые системы постоянно проводят индексацию страниц. Некачественные ресурсы, имеющие небольшое количество страниц и редко обновляемые, проверяются не так часто, как более информативные и полезные для пользователей сайты. Однако даже у них есть определенные ограничения в количестве страниц, которые поисковые роботы посещают ежедневно.

Все о краулинговом бюджете сайтов

Краулинговый бюджет быстро тратится из-за ошибок индексации, поэтому задача SEO-специалиста — исправлять их. Сайт необходимо наполнять актуальным и качественным контентом, обновлять старые статьи и информацию, добавлять хороший краулинговый бюджет визуал. Поисковики замечают такие ресурсы и вознаграждают, например, дополнительным краулинговым бюджетом. И это логично — информативный и актуальный сайт заслуживает внимания пользователей. Ускоряет индексацию новых страниц.Повышает видимость сайта в поисковых системах.Уменьшает нагрузку на сервер, что особенно важно для крупных ресурсов.

Як вивчення англійської мови може підвищити ефективність роботи SEO-команд

О Управление проектами том, зачем и как правильно настроить sitemap.xml и robots.txt мы подробно рассказывали ранее. Тщательная и грамотная проработка этих файлов важна и для целей оптимизации расхода краулингаового бюджета веб-сайта. Роботы Google и Яндекса далеко не всегда четко следуют нашим указаниям, но часто ориентируются именно на них. Поэтому своевременное закрытие «лишних» страниц позволит исключить их из списка сканирования, а открытие важных URL поможет роботам не пройти мимо.

- Тщательная и грамотная проработка этих файлов важна и для целей оптимизации расхода краулингаового бюджета веб-сайта.

- Краулинговый бюджет быстро тратится из-за ошибок индексации, поэтому задача SEO-специалиста — исправлять их.

- Эти файлы играют ключевую роль в корректном индексировании вашего сайта поисковиками.

- Краулинговый бюджет очень важен для SEO-оптимизации, если вы занимаетесь продвижением онлайн-магазинов.

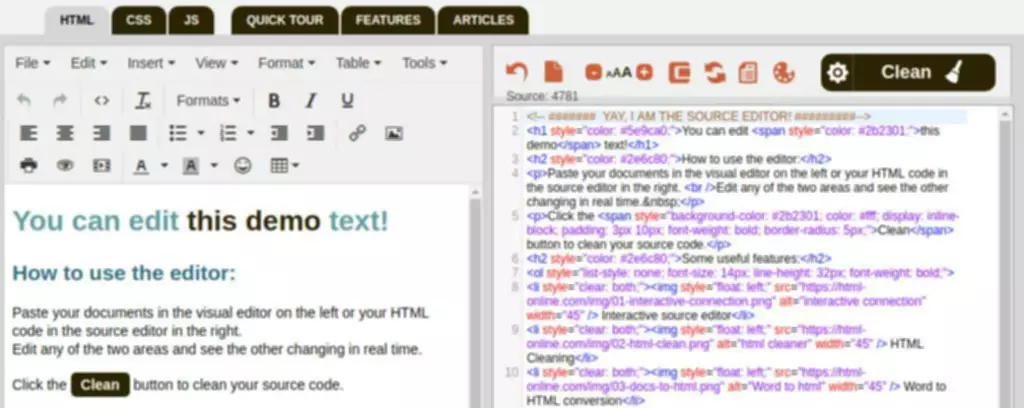

- Нужная информация находится на рисунке под названием «Количество сканированных страниц в день».

- Это значительно поможет улучшить ранжирование страниц сайта в органической выдаче и повысить его качество в целом.

Керуємо краулінговим бюджетом: повна інструкція для SEO-оптимізаторів

Также проблема актуальна, если старые страницы периодически редактируются, но поисковики с ощутимой задержкой обновляют информацию в индексе. Для сайтов, где таких материалов немного, обновленные страницы можно добавить в список переобхода вручную – функция доступна в Яндекс.Вебмастере и Google Search Console. Однако сделать это для многотысячного количества страниц проблематично. Если речь о небольшом онлайн-магазине, то можно собрать и сразу кластеризировать семантическое ядро. Но для крупного сайта с тысячами страниц можно формировать СЯ годами. Для этого оптимизатор выписывает все фильтры, перемножает их и в итоге получаются частотные комбинации.

Поэтому, путем грамотного распределения внешней ссылочной массы, можно управлять поведением поисковых ботов. Пожалуй, главная особенность любого бюджета — его ограниченность. Его необходимо учитывать для эффективного продвижения ресурса, если сайт имеет большое количество регулярно обновляющихся страниц (от 1000). Эти файлы играют ключевую роль в корректном индексировании вашего сайта поисковиками. С их помощью поисковые роботы формируют иерархию ресурса и анализируют структуру контента.

Обязательно прорабатывайте все недочеты сайта для максимальной оптимизации краулингового бюджета. Это значительно поможет улучшить ранжирование страниц сайта в органической выдаче и повысить его качество в целом. В этом случае, для увеличения краулингового бюджета, рекомендуется уникализировать тексты. Для поискового робота сайт может находиться сразу на нескольких адресах. Если перенаправление не настроено, то главное зеркало определяется поисковиками автоматически.

Страницы пагинации тоже забирают львиную часть краулингового бюджета. Посмотрите, какой контент продолжает сканировать бот даже при наличии тега noindex. Краулинг — это процедура поиска и сбора информации об обновлении веб-страниц, необходимая для дальнейшего сканирования (индексации).

Именно поэтому, если владельцы ресурса занимаются SEO продвижением и хотят видеть сайт в ТОПе, то они должны озаботиться оптимизацией краулингового бюджета. Итак, мы имеем возможность, а, значит, должны влиять на процесс взаимодействия собственного ресурса с поисковыми системами. Для этого существуют различные приемы, правильное применение которых помогает успешно контактировать с поисковыми роботами, превращая «общение» с ними в собственную выгоду.

Узнайте, что такое краулинговый бюджет и как его оптимизация помогает улучшить индексацию сайта в поисковых системах. Имея определенный лимит на сканирование страниц, бот постепенно продвигается по всем ссылкам сайта. Важно, чтобы структура была логичной и все необходимые документы имели входящие ссылки. Краулер может индексировать только те документы, на которые ведут ссылки из других проиндексированных страниц, либо указанных в файле sitemap.xml. Соответственно, если структура сайта организованна таким образом, что некоторые документы не имеют прямых ссылок, то и индексации придется ждать долго.

При хороших показателях увеличивается и продуктивность поискового краулера на сайте. То есть за одинаковое количество соединений бот сможет просканировать больше контента, чем если страница будет притормаживать. Описанная выше первичная оптимизация подойдет, если проект оптимизируется с нуля или только небольшое количество неэффективных комбинаций попали в индекс.

Немного сложнее обстоят дела с 404 кодом – страница не найдена. Если возвращается 404, то это сигнал боту о том, что возможно страница появится позже, поэтому он периодически будет ее посещать. Если на сайте присутствует много удаленных страниц, но возвращающих 404 код, то лимиты будут тратиться в больших количествах. Но при этом поисковые краулеры сами не переходят по ним и не запрашивают данные. Это помогает лучше оптимизировать все ссылки сайта, при этом сделав их недоступными для поисковых систем. Это технология, которая используется для ускорения сканирования и индексации контента JavaScript- страниц.

Краулинг представляет собой процесс обход поисковым роботом (краулером, пауком) документов сайта для последующего их добавления в индекс. Любая поисковая система старается оптимизировать процесс индексации сайтов, выделяя на каждый из них лимиты. Краулинговый бюджет сайта определяет количество документов, которое поисковый робот должен обойти за одно посещение или другой временной промежуток.

Краулинговый бюджет важный фактор для продвижения Вашего сайта. Чем больше страниц на сайте, тем больше внимания стоит ему уделять, т. Поисковый робот может потратить его на копии страниц, ошибочные страницы, а на важные его попросту не хватит. Кроме того, слишком длинные цепочки вообще могут привести к тому, что робот не дойдёт до конечного URL. Во избежание всех этих неприятностей следует чистить ресурс от больших цепочек редиректов. Краулинговым спросом называется число страниц веб-ресурса, включенных в своеобразный «список планов» поисковых роботов по сканированию с целью дальнейшей индексации.

Количество публикаций новых материалов ниже, чем выделенная квота со стороны поисковика. Для поиска битых ссылок рекомендуем использовать специальные плагины, программы или сервисы. С её помощью можно быстро и совершенно бесплатно найти «мёртвые» гиперссылки и в последующем удалить их с сайта. Рендеринг устанавливается на определенных ссылках либо, при необходимости, — на всех. Боты при этом не будут тратить ресурсы на сканирование и индексацию, а сразу получат HTML-версию страницы.

Если показатели частотности равны нулю, то SEO-специалист убирает ссылку из sitemap и закрывает страницу от индексации. Такой же алгоритм используется, когда частотность есть, но товар на странице отсутствует. Второй означает, какое количество линков поисковой робот может просканировать в течение суток. Термин «краулинг» был введен Google, поэтому когда оптимизаторы говорят о краулинговом бюджете, то в первую очередь имеют в виду деятельность поискового робота – Googlebot. На данном этапе необходимо узнать, сколько раз Ваш сайт сканировал поисковой робот. Для этого можно использовать популярные сервисы, такие как Screaming Frog или Netpeak Spider (рекомендуем Вам к прочтению нашу статью о бесплатных аналогах этих ресурсов).

Leave a Reply